« Audit SEO » : le terme n’est pas précis, il existe plusieurs formes d’audits. Le plus important de tous, c’est l’audit du site lui-même, exhaustif, tenant compte de toutes les pages, toutes les images, couplé à des données externes (Analytics, Search Console).

Cet article est très complet, rédigé par des experts reconnus (Olivier Duffez de WebRankInfo) et rentre dans des détails d’un bon niveau. Il est très utile et exploitable aussi bien pour les annonceurs que pour les agences.

👱♂️ 👩 Si vous êtes annonceur (vous bossez le référencement de votre propre site ou de celui de votre employeur) :

- la méthode décrite ici vous permet de réaliser vous-même une analyse du référencement de votre site

- vous pouvez aussi l’utiliser pour élaborer un cahier des charges SEO

- si on vous a déjà fourni un rapport d’audit, vérifiez qu’il contient au moins tout ce qui est listé ici

👩💼 👨💼 Si vous êtes prestataire (agence, freelance, consultant indépendant) :

- vous n’aurez sans doute aucun mal à ajouter à votre méthode actuelle les points ci-dessous pas encore inclus dans vos audits

- si vous n’avez pas encore de modèle de rapport d’audit, vous pouvez réutiliser celui fourni ici

L’audit SEO : présentation

Où trouver un exemple de rapport d’audit SEO complet ?

🎁 Nous vous les offrons ! 👏

Nous proposons en effet plusieurs exemples de rapports d’audit qui peuvent vous servir de modèle (très utile si vous êtes une agences web, un freelance ou un consultant SEO) :

- exemple de rapport d’audit SEO généré par RM Tech, extrêmement complet. La version PDF s’obtient par la fonction impression de votre navigateur.

- exemple de rapport d’audit de sitemap et pages orphelines généré par RM Sitemaps.

- exemple de rapport d’audit du maillage interne et de la pagination généré par RM Pagination, avec détection des pages LIP et Fake Depth

Comment avoir un audit SEO gratuit ?

Si vous n’en avez pas encore profité, vous pouvez demander un pré-audit gratuit.

Le rapport obtenu sera complet mis à part qu’il ne contient pas les fichiers annexes.

Un audit SEO est-il suffisant ?

Même avec un rapport d’audit très détaillé, bien rédigé, avec toutes les annexes nécessaires, l’expertise humaine est primordiale. La personne en charge du SEO (qu’elle soit interne ou prestataire) sait mieux que n’importe quel outil juger des priorités, en s’adaptant à chaque situation.

Par contre, le but d’un outil d’audit SEO est de faire gagner le maximum de temps (pour que l’humain se consacre à des tâches à plus haute valeur ajoutée). C’est pourquoi l’audit doit inclure au maximum des indicateurs chiffrés permettant de prioriser les actions.

Un bon outil d’audit sait également repérer des problèmes ou idées d’optimisation qui passeraient inaperçus si seule une analyse manuelle était faite. C’est tout l’intérêt du data SEO, surtout avec des algorithmes conçus par des experts SEO reconnus.

Les étapes de l’audit SEO

Le plus important est de faire un audit technique exhaustif, incluant également une analyse des contenus (hors sémantique) et de la satisfaction de l’internaute. Voici les étapes du plan SEO que nous vous proposons…

👍 Bien entendu, cette méthodologie est déjà incluse dans notre plateforme My Ranking Metrics. Vous n’avez qu’à lancer l’audit en appuyant sur un bouton, et vous pourrez vous concentrer à travailler sur des analyses humaines à haute valeur ajoutée.

Vous remarquerez en lisant ce guide que nous appliquons une sorte d’entonnoir :

- au départ, toutes les URL du site sont à étudier

- ensuite, on se concentre sur celles accessibles sans erreur

- ensuite, seulement sur celles qui sont indexables

Ceci pour éviter de faire des recommandations pour des cas inappropriés (ce que font les outils qui croisent les données sans méthode). Par exemple inutile de reprocher une mauvaise balise title à une page interdite d’indexation. Les audits My Ranking Metrics incluent déjà ce travail, pour vous éviter à devoir le faire par des manipulations pénibles dans Excel.

1 Crawler toutes les URL du site

En partant de l’URL de départ, le crawler doit récupérer chaque page puis suivre chaque lien présent dans la page… et ainsi de suite tant qu’il reste des URL.

Il faut respecter les fichiers robots.txt (sur chaque sous-domaine), tenir compte des URL canonique, des balises hreflang, des balises rel=next/prev, suivre chaque redirection, tenter plusieurs accès aux pages qui ne répondent pas, etc.

Pour aller plus loin, faites un audit RM Sitemaps pour :

- crawler aussi les URL présentes dans votre sitemap

- crawler uniquement une liste d’URL précises (si vous ne voulez pas auditer tout le site)

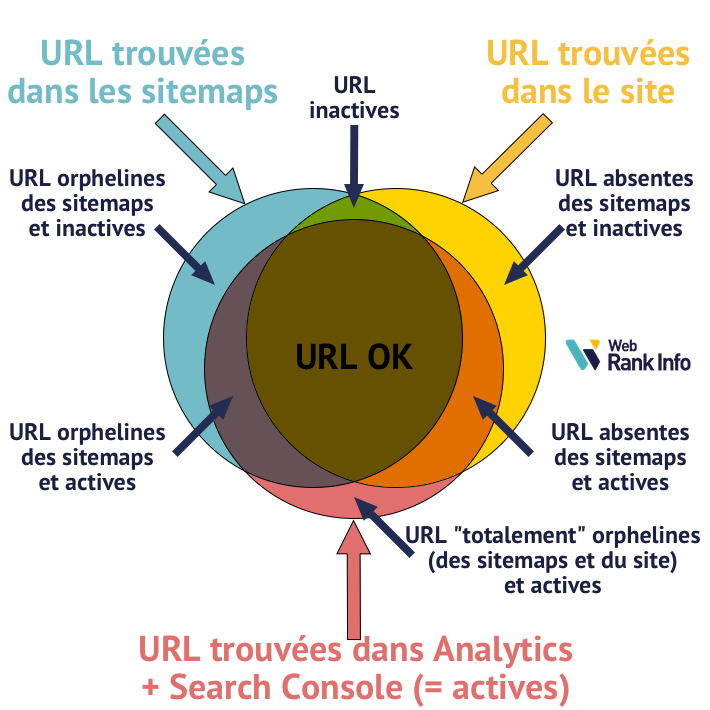

- identifier les pages orphelines, c’est-à-dire celles absentes dans la structure du site (introuvables par des liens)

2 Récupérer les données Analytics et Search Console

Pour chaque URL du site, il faut récupérer les métriques intéressantes dans Google Analytics et Google Search Console. Vous aurez au moins celles-ci :

- nombre de visites générées via le référencement naturel

- nombre de vues (consultations) toutes sources de trafic confondues

et si possible des métriques liées au ecommerce, à la conversion ou à l’expérience utilisateur.

Attention à bien passer par les API officielles de Google et à éviter tout échantillonnage (sinon vous prendrez des décisions basées sur des données fausses).

3 Vérifier que les URL sont accessibles et indexables

Pour chaque URL découverte à l’étape 1, il faut vérifier si elle est interdite de crawl (par une instruction dans le fichier robots.txt). Dans ce cas, il faut la lister dans une annexe mais ne pas la crawler.

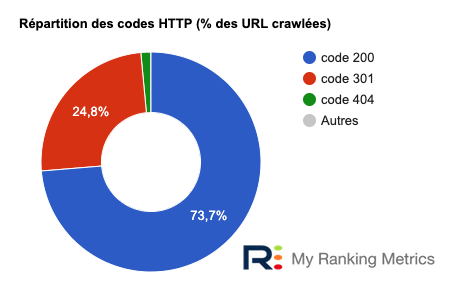

Pour les autres URL (autorisées au crawl), il faut récupérer le code HTTP pour identifier les URL accessibles (code 200). Vous devez pouvoir fournir un décompte similaire à celui qui est inclus dans tous les rapports RM Tech :

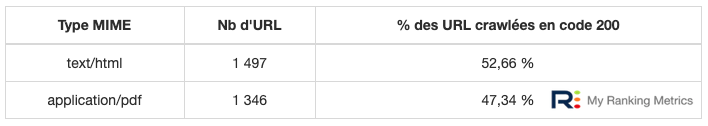

🔍 Continuez l’entonnoir ! Parmi les URL accessibles en code 200, concentrez-vous sur les pages HTML. Basez-vous sur le code MIME et fournissez un compte-rendu de ce type :

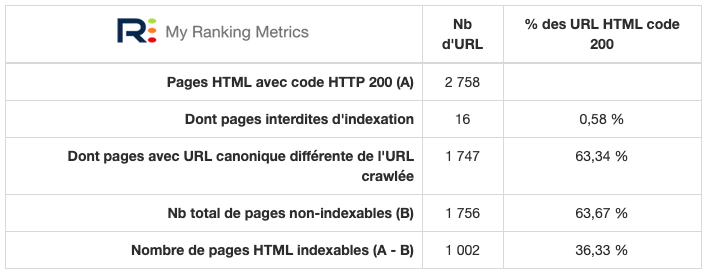

🔍 Continuez l’entonnoir ! Parmi les pages HTML accessibles en code 200, tout le reste de votre audit doit être basé sur les pages indexables. Les pages HTML indexables sont toutes celles :

- qui renvoient un code 200

- et qui ne sont pas interdites d’indexation (via une balise meta robots noindex ou none, ou bien un en-tête HTTP X-Robots-Tag)

- et qui ne contiennent pas d’URL canonique différente de l’URL crawlée

Fournissez un compte-rendu de ce type et listez aussi bien les pages indexables que celles qui ne le sont pas (en indiquant pourquoi). Il faut vous assurer que c’est volontaire de demander à Google de ne pas indexer certaines pages !

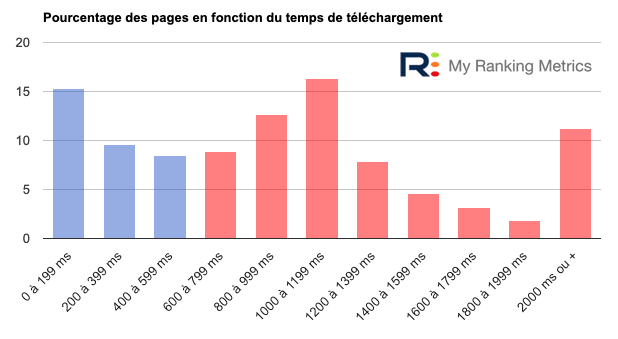

4 Mesurer les temps de téléchargement

Les utilisateurs aiment les pages qui se chargent très vite. Google aussi d’ailleurs : Googlebot crawle plus et de pages et plus souvent quand le téléchargement est rapide.

Vous devez donc mesurer le temps de téléchargement (du code HTML brut, sans aucune ressource comme CSS/JS/images).

🚦 Le saviez-vous ? Google recommande officiellement que le temps de réponse de votre serveur soit inférieur à 200ms (source).

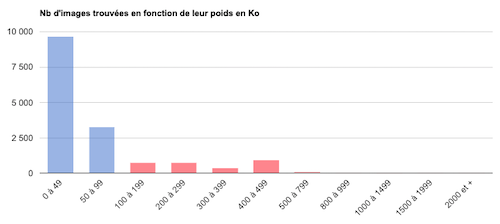

Parmi les ressources qui peuvent être longues à télécharger figurent les images. Là aussi, mesurez le temps de téléchargement ainsi que leur poids (Ko) :

Complétez si possible par une analyse de la vitesse de chargement des pages, avec Google PageSpeed Insights, Lighthouse ou Dareboost. Ne faites pas l’erreur d’analyser seulement le temps de chargement de la page d’accueil ou de quelques rares pages…

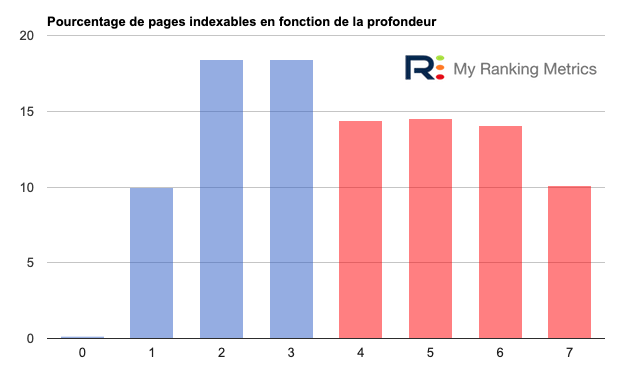

5 Analyser la profondeur et le maillage interne

L’analyse la plus importante à faire est celle de la profondeur des pages indexables. Pour la calculer, comptez le nombre de clics nécessaires (sur des liens internes) pour atteindre la page en partant de l’URL de départ. Ne tenez compte que des liens autorisés au crawl et prenez le plus court chemin quand plusieurs sont possibles.

C’est important de s’y intéresser, car la profondeur d’une page joue sur le référencement : + une page est profonde, + ses performances SEO se réduisent.

La règle des 3 clics ne s’applique pas à tous les sites, il est plus intelligent de s’adapter à la taille du site (nombre de pages à faire indexer). C’est ce que fait RM Tech qui indique la profondeur maximale à éviter de dépasser.

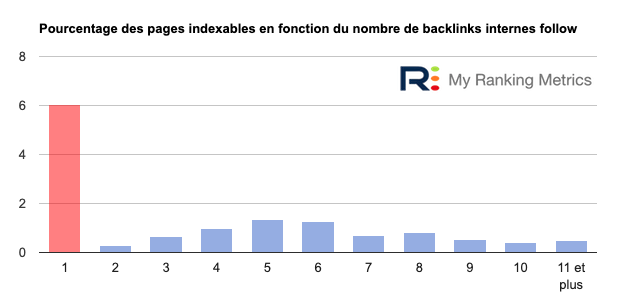

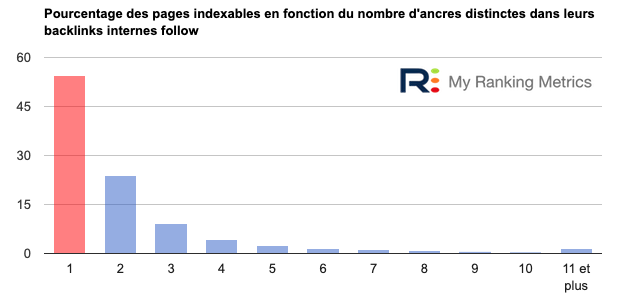

La 2ème analyse du maillage à faire consiste à compter pour chaque page indexable le nombre de liens entrants internes (backlinks internes). Les pages ayant un lien depuis le menu ont donc beaucoup de liens, les autres parfois trop peu. Les pages stratégiques doivent avoir plusieurs liens.

La 3ème analyse du maillage à faire consiste à étudier le texte cliquable des liens entrants internes (anchor text en anglais). Il est très efficace en référencement d’avoir de la variété dans les ancres, tout en restant naturel.

Astuce : la communauté SEO admet que Google semble ne tenir compte que du 1er lien quand une page A fait plusieurs fois un lien vers la même page B. C’est pourquoi RM Tech gère nativement ce point particulier du maillage. C’est utile pour identifier l’impact SEO d’un menu (encore plus d’un méga menu), des liens nofollow internes (PageRank sculpting) et des ancres de liens. Une annexe détaille tous les liens trouvés, numérotés dans le cas des liens multiples A vers B.

Pour aller plus loin dans l’analyse du maillage, faites un audit RM Pagination pour :

- vérifier le respect des bonnes pratiques de la pagination

- identifier s’il y a trop de pages de pagination (page 2, page 3, etc.) car elles sont très peu efficaces

- mesurer les performances des pages en fonction de leur rang dans la pagination

- trouver s’il y a des pages LIP ou avec Fake Depth (voir « Bonus » ci-après)

6 Analyser les balises Title, Meta description et Hn

Ces vérifications sont très classiques mais reste indispensables. Voyez les détails dans notre exemple de rapport d’audit, mais faites au moins ces tests :

- Balise title : ni trop longue ni trop courte, sans mots répétés à outrance (keyword stuffing), sans doublons, avec des libellés qui donnent envie de cliquer dans les SERP. Pour en savoir plus : guide WebRankInfo de la balise title

- Balise meta description : présente et pas trop courte, incluant généralement la marque ou le nom du site. Pour en savoir plus : dossier WebRankInfo sur la meta description

- Balises H1-H2…H6 : la balise H1 est la seule indispensable (pas trop longue, sans doublons sur le site) et pour les autres c’est du bon sens. Pour en savoir plus : dossier WebRankInfo balises H1 H2 Hn

7 Vérifier le contenu dans la zone principale de chaque page et les contenus dupliqués

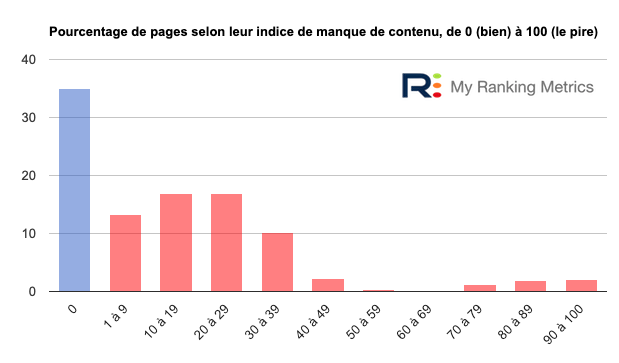

Même si ce n’est pas toujours indispensable, il est hautement recommandé d’avoir « assez » de contenu dans la zone principale de la page. Nous pouvons l’affirmer après avoir fait une étude big data SEO que nous vous incitons à consulter.

RM Tech fait une analyse très efficace à ce niveau :

- c’est la zone principale de contenu qu’il faut étudier. Si votre outil compte le nombre total de mots dans toute la page, ça ne sert strictement à rien.

- un site ecommerce n’est pas travaillé comme un site éditorial. Une fiche produit n’est pas comparable à une page d’accueil, un listing ou un article de blog. RM Tech sait tenir compte de tout ça. Il repère le type de CMS pour affiner l’analyse (WordPress, PrestaShop, Joomla, Drupal, WooCommerce, Magento, SPIP, TYPO3 CMS, osCommerce, eZ Publish, CMS Made Simple, OpenCart, Blogger, phpBB, Shopify, Oxatis…).

Montrez un bilan sous forme visuelle, comme ici dans RM Tech :

Complétez par une recherche du contenu dupliqué sur l’ensemble du site Internet : il s’agit de contenus présents à plusieurs URL. Parfois il s’agit d’une erreur technique ou d’un mauvais réglage du CMS. Les moteurs de recherche n’aiment pas le duplicate content car ça leur fait perdre des ressources (cf. définition de crawl budget en SEO et source Google)

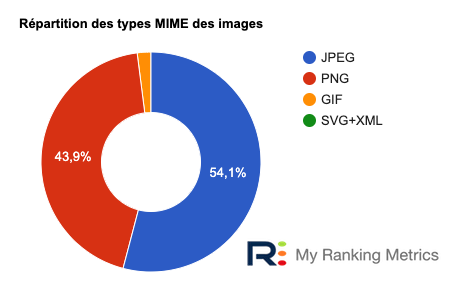

8 Analyser toutes les images

Les images sont indispensables pour améliorer l’expérience utilisateur et même pour le référencement. A condition de vérifier que tout est bien fait !

Voici les 6 points de contrôle des images effectués par RM Tech en termes SEO :

- crawler le site et chercher toutes les balises <img>

- repérer celles qui sont bloquées au crawl

- vérifier le code HTTP (cf. images cassées)

- vérifier le format d’image (PNG, JPEG, SVG, GIF, etc.)

- vérifier l’indexabilité (noindex, URL canonique)

- vérifier l’attribut ALT

Voici les 6 points de contrôle des images effectués par RM Tech en termes UX :

- vérifier le poids de chaque image (Ko) pour repérer les trop lourdes

- calculer le poids total des images par page (Ko)

- mesurer le temps de téléchargement de chaque image (ms)

- comparer la taille de chaque image (pixels) à celle indiquée en HTML

- chercher s’il y a des images en HTTP dans pages HTTPS

- calculer le nb total d’images par page (pour repérer les cas extrêmes)

A voir aussi : le guide WebRankInfo pour bien référencer ses images

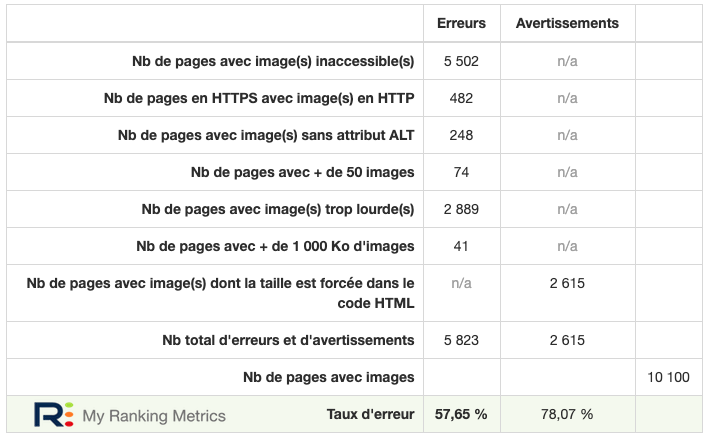

En plus de l’analyse des images elles-mêmes, n’oubliez pas d’analyser les pages qui les incluent. Par exemple, une page peut contenir trop d’images (ça peut finir par être trop lourd ou complexe) ou les afficher à des tailles différentes de l’image réelle.

Votre audit doit donc inclure un bilan des pages contenant des images, comme celui-ci :

9 Analyser les liens sortants

Rappelez-vous de la « loi Google » (source) :

Tout lien destiné à manipuler le classement d’un site dans les résultats de recherche Google peut être considéré comme faisant partie d’un système de liens et comme constituant une violation des consignes Google aux webmasters. Cela inclut toutes les opérations visant à manipuler les liens dirigeant vers votre site ou les liens contenus dans votre site et redirigeant vers d’autres pages.

Consignes de Google relatives à la qualité (Systèmes de liens)

C’est pourquoi votre audit doit obligatoirement inclure une vérification de tous les liens sortants (pointant vers d’autres sites). Pour chaque lien, vérifiez :

- le code HTTP : pour trouver les liens cassés (404) ou ceux qui redirigent vers un autre site que lui prévu initialement

- l’anchor text (texte cliquable) : vous ne devez pas faire un lien « bourré de mots-clés » artificiel

- la balise title de la page (finale) de destination : pour vérifier de quoi elle parle

✌️ Cette analyse est incluse nativement dans RM Tech !

10 Calculer un indice de qualité intrinsèque de chaque page

OK, vous avez bien bossé ! Les étapes précédentes représentent déjà un gros travail d’analyse et devraient fournir de nombreuses recommandations SEO.

Justement : vous avez une masse énorme de données et au final trop d’actions à mettre en place. Comment prioriser ? Par quoi commencer ?

Nous vous conseillons de calculer pour chaque page indexable un indice lié à sa qualité intrinsèque. Dit autrement : en cumulant tous les défauts, erreurs ou sous-optimisations de la page, vous devriez pouvoir calculer une sorte de note de synthèse de la page.

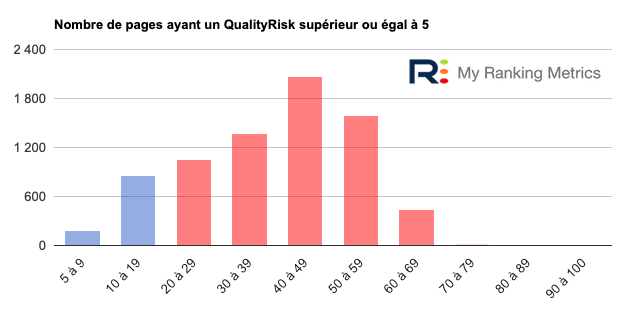

Dans RM Tech, nous l’appelons QualityRisk. Entre 0 (aucun problème) et 100 (problème maximal), l’indice aide à identifier très rapidement les pages qui risquent d’avoir le plus de difficultés en référencement. Généralement, il s’agit aussi de pages qui risquent de décevoir l’internaute…

💡 Pour en savoir plus, lisez le dossier WebRankInfo sur QualityRisk.

Dans l’annexe principale de l’audit, vous avez la liste de toutes les pages indexables (et toutes leurs caractéristiques mesurées ou calculées). Vous pouvez la trier par l’indice QualityRisk.

11 Calculer un indice de performance SEO de chaque page

Si vous n’avez pas accès à des données liées aux performances effectives des pages (c’est le cas pour un devis), alors QualityRisk est le mieux que vous puissiez faire.

Mais pour un audit complet, il est impératif d’avoir accès à Google Search Console et Google Analytics (ou équivalent). En effet, vous pourrez calculer un indice encore plus précis pour chaque page, combinant sa qualité intrinsèque et la réalité de son utilité/attrait pour l’internaute.

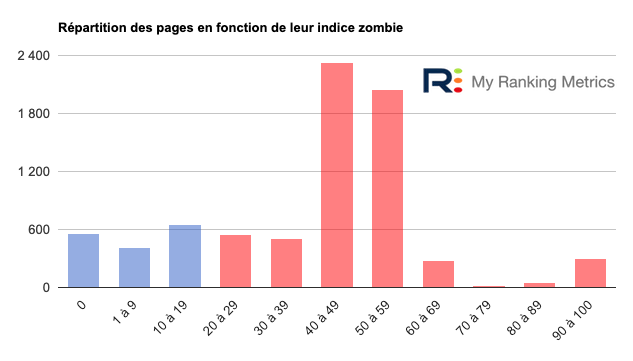

La méthode Pages Zombies (WebRankInfo) est la plus avancée à ce niveau. Elle est incluse de façon native dans RM Tech ! Elle permet de repérer les pages qui cumulent tous les problèmes et qui ne sont pas efficaces, même cachées au milieu de (centaines de) milliers de pages.

Attention, le but de la méthode Pages Zombies SEO n’est pas de supprimer ou désindexer les pages zombies (indice élevé). En gagnant un temps fou (à les repérer), le but est d’identifier la cause des problèmes afin de les corriger et d’améliorer significativement le référencement naturel du site. Les conseils SEO fournis dans l’audit sont alors bien plus faciles à exploiter.

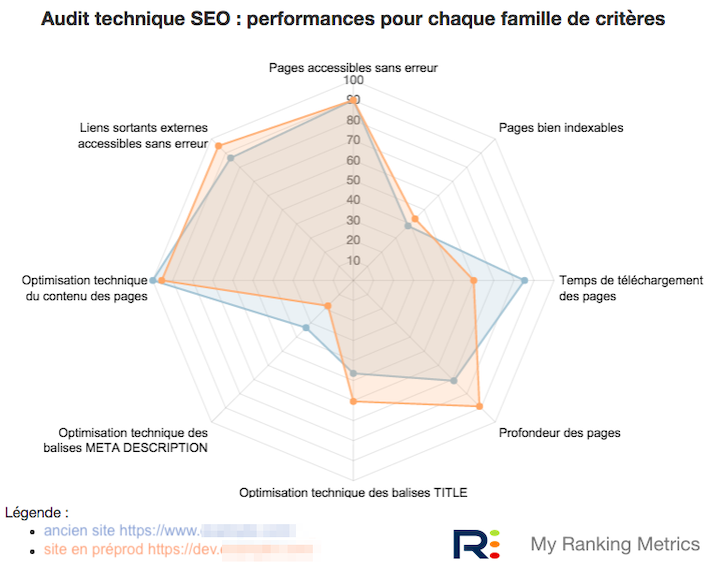

12 Faire une conclusion avec score SEO et schéma de synthèse

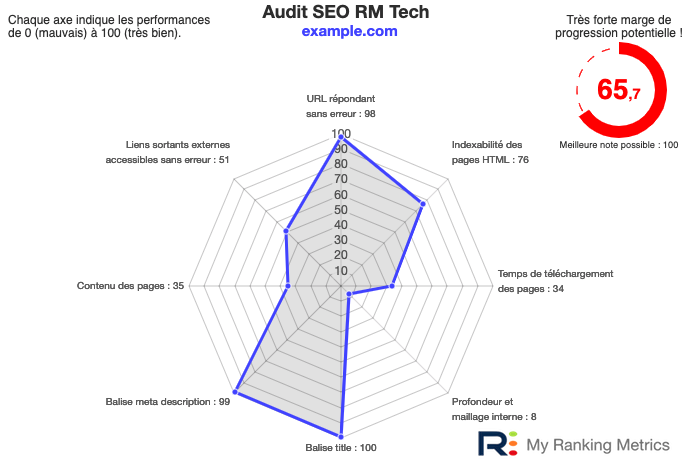

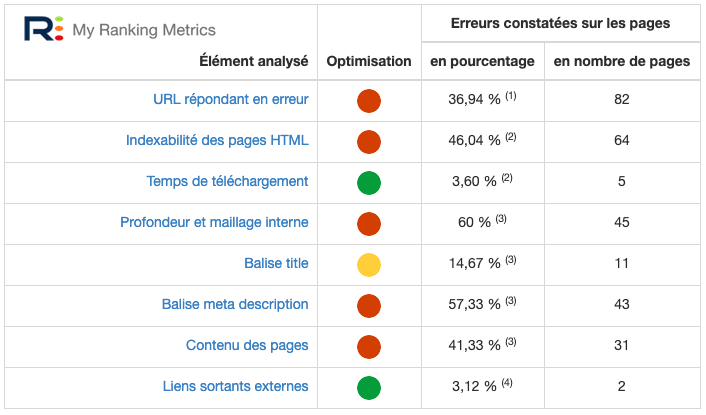

Tout bon audit doit avoir une conclusion ou une synthèse sur l’optimisation SEO. Elle doit fournir quelques chiffres représentant bien l’ensemble des éléments analysés, ou les plus importants.

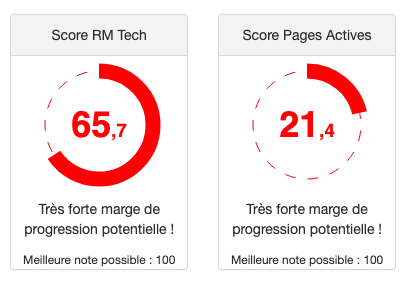

Le diagramme en radar à 8 axes inclus dans RM Tech est très apprécié :

Certains préfèrent un tableau de synthèse avec des chiffres comme ici :

C’est souvent très utile de fournir un score global, par exemple sur une échelle de 0 (mauvais) à 100 (excellent). D’une part car cela motive pour l’améliorer, d’autre part ça aide à avoir des repères (d’un audit à l’autre du même site, ou d’un site à un concurrent).

RM Tech fournit un score SEO représentant l’optimisation technique SEO du site lui-même. Il est complété par un score Pages Actives représentant l’efficacité SEO des pages (réussissent-elles à générer des visites ?).

bonus Trouver des quick wins

Parfois, plutôt que de corriger des problèmes 😩 on préfère travailler sur des aspects plus positifs 😀

Ou alors, on souhaite trouver des moyens efficaces et rapides pour améliorer son référencement Google. Par exemple après avoir subi une pénalité algo lors d’un update de Google…

Les outils d’audit de My Ranking Metrics vous mâchent le travail ! Voyez les explications ci-après.

Quick Win SEO n°1 : pages les plus rentables à travailler en 1er

Si vous avez bien respecté les étapes précédentes, vous avez calculé pour chaque page indexable son indice de qualité (évaluation du SEO de la page).

Mais si vous commencez à travailler les pages qui ont le plus de problèmes, vous allez dépenser une énergie folle pour passer de la page 8 à la page 4 des résultats Google. Et donc obtenir aucun trafic.

Voici la recette à suivre, très schématique :

- Listez vos pages indexables

- Calculez leur indice QualityRisk (il indique la marge de progression possible en SEO)

- Récupérez leurs performances actuelles (nb de visites organic générées, nb d’impressions et position moyenne selon search console, etc.)

- Combinez pour trouver les pages les plus rentables à travailler en premier (celles qui ont une bonne marge de progression ET que Google « aime déjà »)

✌️ Cette analyse est incluse nativement dans RM Tech !

Quick Win SEO n°2 : pages orphelines

Une page orpheline est une page qui existe bien (accessible, et même indexable) mais qui ne fait pas partie de la structure du site. Cela signifie qu’il n’existe aucun lien vers la page, depuis les autres du site.

RM Sitemaps contient plusieurs algorithmes pour repérer tous les cas de pages orphelines.

A vous ensuite de traiter les 2 types :

- les bonnes pages orphelines : il s’agit d’une page de qualité, qui ne devrait pas être orpheline. La relier au reste du site est très efficace, ça améliore souvent son référencement de façon rapide. Il suffit de trouver d’autres pages de la même thématique et d’y insérer des liens.

- les mauvaises pages orphelines : il s’agit de pages qui ne devraient pas exister (ou ne pas être indexables). Il suffit des les « nettoyer » (supprimer, désindexer, regrouper…).

💡 Pour aller plus loin, appliquez ces techniques avancées avec les sitemaps.

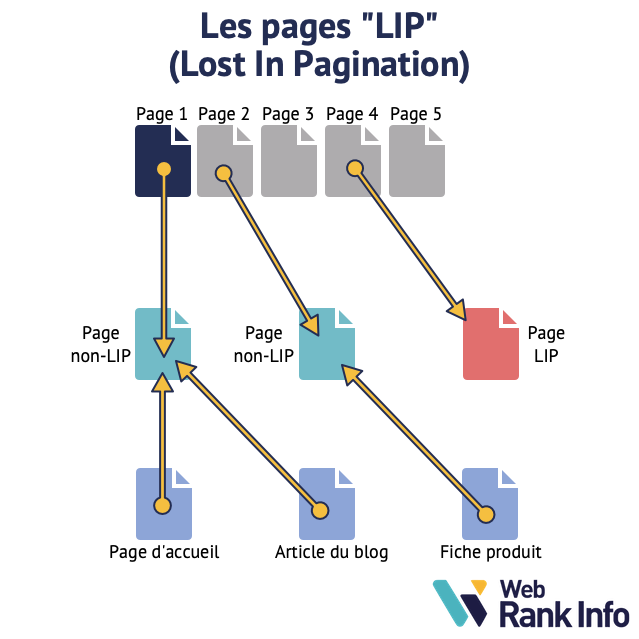

Quick Win SEO n°3 : pages LIP

Selon la définition de page LIP sur WebRankInfo :

Une page LIP (Lost In Pagination) est une page dont les liens entrants internes ne proviennent que des pages de pagination (page 2, page 3, etc.).

WebRankInfo

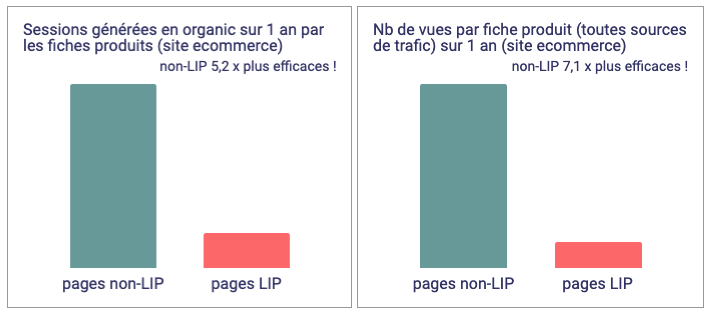

Les pages LIP sont très peu efficaces : difficiles à trouver par l’internaute et mauvaises en référencement. Voyez cet exemple :

✌️ RM Pagination détecte automatiquement la présence des pages LIP (c’est le seul outil d’audit SEO dans le monde qui le fasse). Si vous en avez sur votre site, c’est très rentable de corriger les pages concernées.

Quick Win SEO n°4 : pages avec Fake Depth

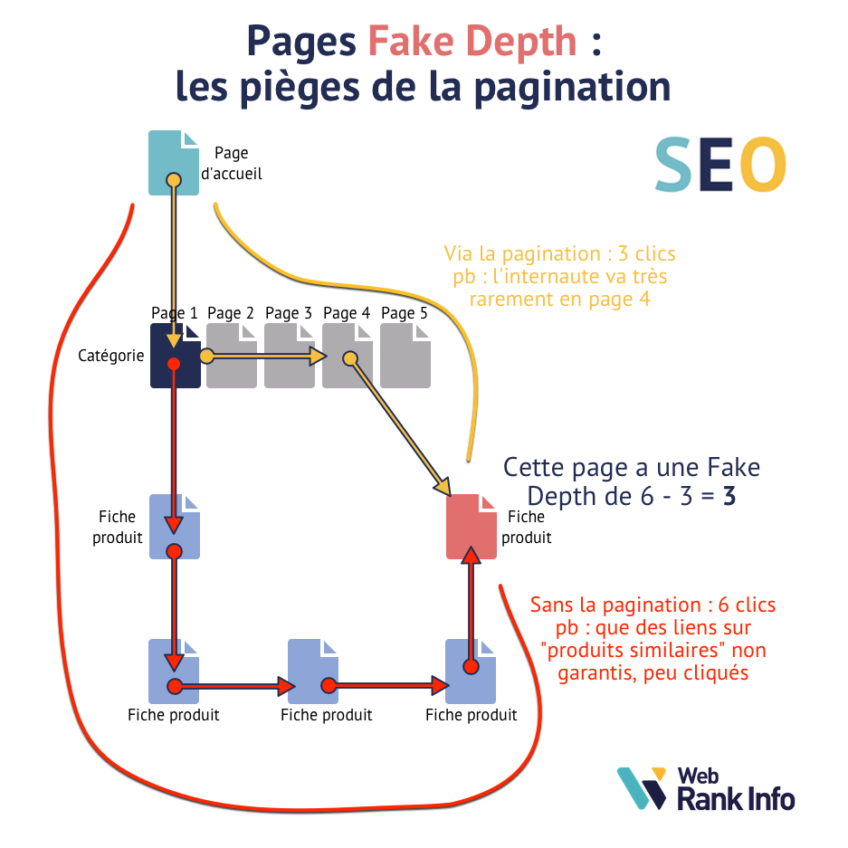

Dans le même style que les pages LIP, nous avons innové avec le concept de Fake Depth (littéralement, fausse profondeur). L’idée est que la méthode traditionnelle de calcul de la profondeur (celle que nous utilisons dans RM Tech) est en quelque sorte parfois faussée par la pagination.

Si le chemin le plus court pour atteindre une page est de passer par les pages 2+ de la pagination (où les internautes ne vont presque jamais), alors le calcul traditionnel est faussé. D’où l’appellation de « fausse profondeur ».

La valeur Fake Depth d’une page est donc l’écart entre

- la profondeur calculée de façon traditionnelle

- et la profondeur calculée en évitant les pages 2+

Voici une explication en image pour une page avec Fake Depth 3 :

✌️ RM Pagination détecte automatiquement la présence des pages Fake Depth (c’est le seul outil d’audit SEO dans le monde qui le fasse).

Grâce aux couplages avec Google Analytics et Google Search Console, RM Pagination peut comparer les performances des pages à profondeur égale, selon qu’elles ont du Fake Depth ou pas. Voici un exemple :

Si vous avez des pages avec Fake Depth, il est impératif de les identifier et de corriger la situation. Leur trafic SEO devrait alors fortement augmenter !

Quick Win SEO n°5 : pages pouvant arriver en page 1 de Google

Voilà exactement un algorithme créé spécialement dans l’optique « Quick Win ».

Voici la recette :

- Listez vos pages indexables

- Calculez leur indice QualityRisk (il indique la marge de progression possible en SEO)

- Récupérez leurs performances actuelles (nb de visites organic générées, nb d’impressions et position moyenne selon search console, etc.)

- Combinez pour trouver les pages qui non seulement sont en position moyenne proche d’arriver en page 1 de Google mais qui ont aussi une bonne marge de progression

Pour les détails, lisez le dossier WebRankInfo qui explique comment arriver en page 1 de Google.

✌️ Cette analyse est incluse nativement dans RM Tech !

Quick Win SEO n°6 : pages décevant trop d’internautes

L’idée est la suivante : si vous décevez trop un internaute qui arrive sur votre site en provenance de Google, alors ça envoie sans doute un mauvais « signal » à Google. Dans le jargon du search marketing, on appelle pogosticking le fait de cliquer sur un résultat des SERP, de rester pas longtemps sur le site puis de revenir dans les SERP. Bref, de faire des allers-retours.

+ ça arrive sur votre site, + c’est mauvais

Et même si ce n’est pas pris en compte par Google (les avis sont partagés), c’est très mauvais pour votre propre business puisque vous décevez vos utilisateurs.

Voici la recette :

- Listez vos pages indexables

- Calculez plusieurs métriques liées à la page elle-même, qui sont liées à la déception probable de l’internaute (contenu très faible dans la zone principale, trop grande lenteur, incompatibilité mobile, etc.)

- Récupérez leurs performances (nb de visites organic générées, temps moyen passé, nombre moyen de pages vues par visite, etc.)

- Combinez pour trouver les pages qui non seulement risquent fort de décevoir, mais génèrent aussi beaucoup de visites. La « masse » de déception est alors grande.

✌️ Cette analyse est incluse nativement dans RM Tech !

Pour les détails, lisez nos explications Comment repérer les pages qui déçoivent les internautes.

Autres analyses

Remarque : si vous suivez cette checklist SEO en entier, ce sera déjà très efficace. Nous vous conseillons aussi la lecture sur WebRankInfo du tuto pour améliorer votre référencement Google. Mais pour aller encore plus loin et avoir un audit de référencement complet, nous vous conseillons de compléter par :

- l’audit de chaque modèle de page (par exemple catégorie, fiche produit, article de blog…) fournit des recommandations qui seront appliquées sur toutes les URL basées sur ces templates. L’effet de levier est très rentable pour améliorer les performances SEO du site. Nous le faisons depuis 2003 dans nos prestations, voyez les détails ici (connecté à votre compte My Ranking Metrics).

- l’audit de contenu pour établir une stratégie de contenus et aboutir à une liste de mots-clés, pour vérifier ensuite l’adéquation mots-clés/contenus existants et faire les améliorations nécessaires

- l’audit de l’UX : l’expérience utilisateur est devenue très importante aussi bien pour le SEO Google que pour le taux de conversion

- l’audit de positionnement consiste à vérifier en quelle position se trouvent les pages de votre site dans les résultats Google, pour toutes les requêtes stratégiques (mots-clés). Vous pouvez utiliser un outil spécialisé ou plus simplement le rapport gratuit « Performances » dans la Search Console.

- l’audit de Google Analytics (ou de toute autre solution de web analytics) pour vérifier que votre plan de marquage (code de suivi) est bien en place sans erreur, et que votre compte est bien paramétré avec les propriétés, vues et filtres adéquats

- l’analyse des logs permet de mieux comprendre les URL crawlées par Googlebot (et les autres robots, dont des crawlers sans intérêt)

- l’audit de vos backlinks (netlinking) n’est réellement utile que si vous avez abusé de pratiques non conformes aux consignes de Google (achat de liens, liens posés par vous-même, PBN et autres réseaux de sites, liens dans des annuaires de mauvaise qualité, etc.)

Suivez aussi ma liste des points à vérifier en SEO pour éviter de chuter à un update Google.

Les experts SEO de MyRankingMetrics

Tous les outils, tutos et webinars de MyRankingMetrics sont conçus et réalisés par nos 2 experts SEO